Des axes pour la Désindexation

Nous avons vu précédemment que, pour un nom de domaine donné, l’examen des pages indexées sur google pouvait réserver bien des surprises quant au nombre et la nature des URLs listées dans les pages de résultats (serps) du moteur. Dans le cas où il faut nettoyer l’index de Google, plusieurs méthodes existent pour se débarrasser des URLs. En voici quelques-unes plus ou moins efficaces.

1) La redirection 301 :

La redirection 301, par définition définitive, indique que le contenu concerné par l’ancienne URL est désormais renvoyé vers une nouvelle page. Cette technique permet de récupérer le « jus » SEO de la page initiale : on la réservera surtout pour des pages avec un contenu notable en adéquation avec la page cible (et surtout pas les pages spammées !).

Fût un temps pas si lointain où les URLs redirigées en 301 étaient éjectées rapidement de l’index au profit de la cible. Désormais, les URLs redirigées peuvent demeurer visibles dans les serps durant plusieurs semaines, voire plusieurs mois, si ce n’est même plusieurs années (cas observés lors de changement d’extension, avec l’ancienne extension associée à un autre serveur) ! Attention à la redirection 302 (temporaire) : il y a de fortes chances pour que l’url redirigée de cette manière ne soit jamais désindexée (dans certains cas, on peut d’ailleurs squatter certaines positions ☺ ). Si vous êtres pressés, mis à part pour les URLs pertinentes pour les raisons de récupération de « jus » évoquées plus haut, passez plutôt à la solution 4 ou 5.

2) Réponses 404 / 410 :

Si ce n’est pas déjà le cas, on peut forcer des réponses http qui traduisent la suppression des URLs visées (règles dans le .htaccess, désactivation de fonction à l’origine d’URLs dynamiques, suppression de pages dans le CMS etc..). 404 et 410 indiquent ainsi respectivement une suppression temporaire ou définitive des URLs. Contrairement au 301, elles ne redistribuent pas le « jus SEO », mais elles traînent aussi un certain temps dans l’index. De par leur nature, les réponses 410 étaient plus efficaces pour désindexer une URL il y a quelques années, mais là aussi, la vitesse d’éradication de ces pages dans les serps paraît désormais aléatoire (et les pontes de Google ont d’ailleurs déclaré que 404 et 410 étaient considérées de la même manière). Quoiqu’il en soit, réservez la méthode aux pages mal positionnées et/ou sans contenu.

3) URLs Canonique

Si pour diverses raisons techniques vous voulez éviter les redirections et / ou souhaitez que les visiteurs puissent accéder malgré tout aux URLs que vous voulez supprimer de l’index (par exemple des pages issues du filtrage des résultats d’une autre page, très classique dans le e-commerce), apposer une URL canonique (classiquement : <head>… <link rel= »canonical » href= »URL de destination » /> … </head>) correspondant à une URL active qui délivre la même information, assure à terme la désindexation d’une grande partie des pages concernées.

Pour les pages sans intérêt pour les visiteurs, on pourra aussi proposer une page sans contenu comme URL canonique : pour avoir vu plusieurs fois se désindexer des quantités de pages suite à une erreur de développement, je peux vous garantir l’efficacité de la méthode ! En revanche, toutes ces pages resteront actives et seront sans cesse évaluées par Google, sollicitant une partie des précieuses ressources du GoogleBot lors du crawl si ces URLs sont accessibles. Aussi, une fois la désindexation effective, il vaut mieux bloquer ces pages aux robots via le fichier robots.txt et sa directive disallow.

Notons que l’on peut définir des règles génériques via le fichier .htaccess. Par exemple, si vous voulez que tous vos fichiers pdf « /nom.pdf » pointent automatiquement au profit des pages « /dossier/nom.html », lesquels possèdent les mêmes contenus, on ajoutera (pour un serveur Apache) :

RewriteRule ([^/]+)\.pdf$ – [E=FILENAME:$1]

<FilesMatch « \.pdf$ »>

Header add Link ‘<http://www.monsite/dossier/%{FILENAME}e.html>; rel= »canonical »‘

</FilesMatch>

Ou au cas par cas :

<FilesMatch « dossierX.pdf »>

Header add Link ‘<http://www.monsite/UnAutreDossier/dossierX.html>; rel= »canonical »‘

</FilesMatch>

4) Directive Noindex

Cette directive assure une désindexation rapide dès lors que la page est crawlée, d’où plusieurs contraintes :

– Si les pages sont bloquées par le robots.txt (disallow), il faut les débloquer préalablement pour que Google puisse les visiter et lire la directive ! En revanche, une fois la désindexation prise en compte, bloquez les pages via le robots.txt pour éviter que Google perde ses ressources sur ces pages lors du crawl.

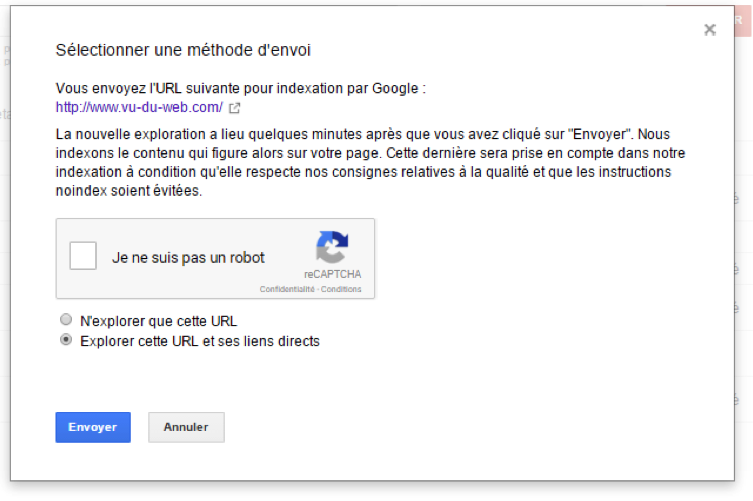

– Si la page est orpheline, il peut se passer un bon moment avant que Google ne la réévalue, donc il veut mieux soumettre sont URL via la Google Search Console (« Explorez comme Google »). En revanche, la méthode sera délicate si plusieurs milliers d’URLs sont concernées, car même en automatisant la procédure (via iMacros par exemple), seule l’évaluation mensuelle de 500 URLs est possible par cette méthode. Une astuce pour éviter d’insérer une par une de nombreuses urls (sans passer par iMacros) : créez temporairement une page avec toutes les URLs que vous voulez désindexer (via la méthode précédente ou la méthode classique). Sur Google Search Console, demandez l’exploration de la page, puis, dans un second temps, demandez l’indexation de cette page avec tous ses liens directs (figure ci-dessous). Attention, vous ne pouvez faire cette opération que 10 fois par mois !

– Evitez également d’ajouter « nofollow » pour que le Google Bot puisse poursuivre les liens associés.

Classiquement, la directive s’insère dans le <head> de la page à désindexer : : (<meta name= »robots » content= »noindex »/>) mais vous pouvez notamment désindexer tout un lot d’URL avec paramètres avec la directive X-Robot-Tag du serveur. Par exemple, sur Apache, on pourra insérer dans le .htaccess :

RewriteCond %{QUERY_STRING} ^monparametre=(.*)$ [NC]

RewriteRule . – [E=headernoindex]

Header set X-Robots-Tag « noindex,follow » env=headernoindex

Google donne également une solution pour désindexer les URLs à partir de leur extension, par exemple pour désindexer les pdf :

<Files ~ « \.pdf$ »>

Header set X-Robots-Tag « noindex, nofollow »

</Files>

5) Demandez directement à Google !

Les pages redirigées, les URLs qui répondent en 404, 410 ou encore celles bloquées par lefichier robots.txt, peuvent être désindexées via la Google Search Console ( » Index Google » -> » URL à supprimer » ).

Demandez le masquage des pages de résultats et la suppression du cache. La méthode est très rapide mais nécessite de rentrer les URLs une par une. Donc, si vous avez une très grande quantité d’URL à désindexer, passez plutôt par un logiciel d’automatisation (IMacros)

En fonction des cas de figure et pour diverses raisons, vous pouvez utiliser l’une et/ou l’autre de ces méthodes de désindexation. Si vous avez un doute ou désirez des précisions, que vous n’arrivez toujours pas à nettoyer l’index de Google de vos urls, n’hésitez pas à nous contacter !